SVM

支持向量机

1.模型表示

支持向量机是一种二分类的广义分类器,其假设函数为

决策函数为:

2.优化准则

支持向量机运行的是基于边界决策的优化准则,决策边界不止一条 = 模型参数不唯一这种时候就要寻找中间线。

使$b=\theta_0$,其余部分视为$\vec w^T\vec x$的话,那么寻找中间决策线的方程就可以表述为:

1.点到超平面的距离

其中,$||\vec w||$表示一个二范数的模,这个式子的大前提是同时使得正样本大于0,负样本小于0

在r的集合中,间隔定义为$r = minir^{(i)}$,间隔最大化则是求$max{\vec w,b} r$的过程

最终约束条件:

3.优化目标loss

loss的意义:平行超平面$\vec w^T\vec x+b_1=0$与$\vec w^T\vec x+b_2=0$之间的距离

即辅助决策边界之间的距离$d=\frac{2}{||\vec w||}$

loss的最大化的d就是让决策边界到正负样本之间的安全距离最大

4.参数求解(对偶优化)

原问题:

构造拉格朗日函数:

等价于:

由于强对偶性,交换min,max下的$\vec w,b与\vec \alpha$也同样成立

求解对偶问题的过程就是求拉格朗日函数的过程。

对偶问题的等价推广条件:KKT条件

- $g(\vec \theta)\leq 0$ 原问题可行

- $\vec \alpha\geq0$ 对偶问题可行

- $g(\vec \theta)\vec \alpha=\vec 0$互补松弛

其中$\vec {\theta^*}$是$\vec \theta$的最优解

决策函数

5.SVM优点

- 小样本学习(但学习过程中所有样本依然参与运算,给少量样本和大量样本意义相同)

- 分类鲁棒性高

- 理论上可得全局最优解

6.软间隔(线性不可分的情况)

由于线性不可分,则无论什么分法都会将样本分错。可以设$\varepsilon$作为对难分样本的容忍度,loss就是要获得最小的$\varepsilon_i$,公式为

这里的C是一个常数,用来调和两项的系数

软间隔的优化目标

拉格朗日函数:

软间隔支持的向量满足:$y^{(i)}(\vec w^T\vec x^{(i)}+b)+\varepsilon_i=1$

优点:小样本学习,可以容忍一些难以分类的样本点

7.核技巧解线性不可分问题

核技巧的基本思想是:低维线性不可分的问题可以转化为高维线性可分的问题

核函数表示:

这是对特征距离的一种重新度量。

常用和函数:

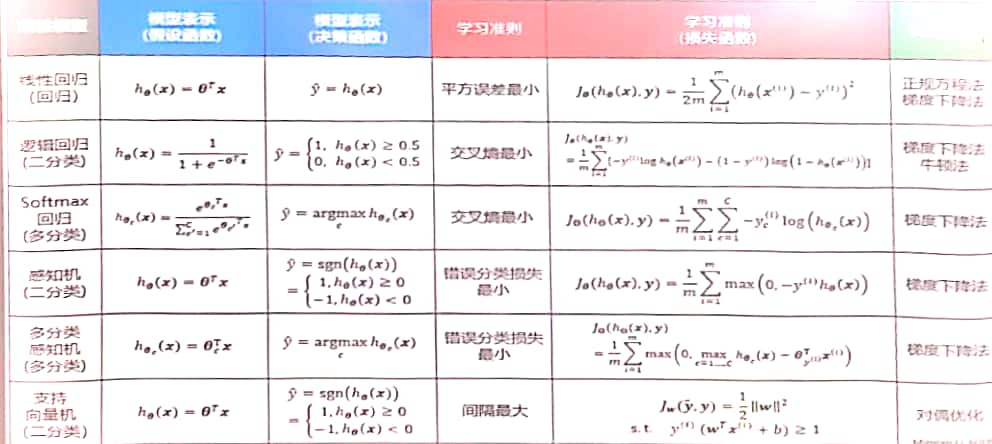

线性模型总结